4 mai 2023

Tiny-ML : une alternative décentralisée et moins énergivore pour l'IA

L’intelligence artificielle (IA) fait désormais partie de notre quotidien, de nos bracelets connectés à nos smartphones. Comment est-il possible de déployer de tels algorithmes dans ces environnements ayant de fortes limitations énergétiques ? Dans cet article, publié initialement le 20 mars par ICT Journal, Andrea Dunbar, Group Leader, Edge AI and Vision au CSEM et le doctorant Simon Narduzzi présentent les avantages de TinyML pour alléger le Cloud ainsi que les défis de demain.

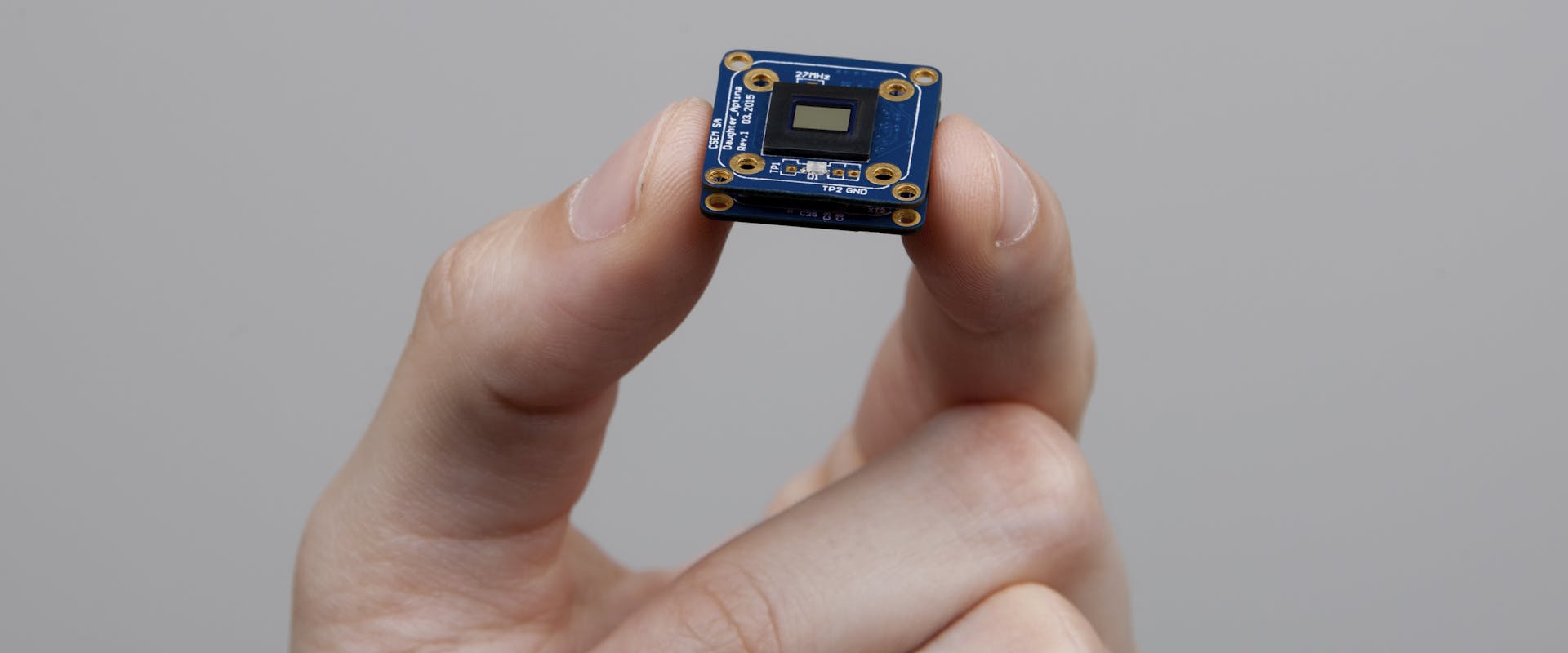

© CSEM - Le module Vision-in-Package (VIP) est un dispositif mobible efficace de vision par ordinateur.