4. Mai 2023

Tiny-ML für dezentralisierte und energieeffiziente KI

Künstliche Intelligenz ist mittlerweile Teil unseres Alltags, eingebettet in vernetzten Armbändern bis hin zu Smartphones. Wie ist es möglich, solche mächtigen Algorithmen in Umgebungen zu integrieren, wo jedes Milliwatt zählt? In diesem Artikel, der erstmals am 19.3. auf der Website von Netzwoche erschienen ist, zeigen Andrea Dunbar, Group Leader, Edge AI and Vision beim CSEM und der Doktorand Simon Narduzzi auf, wie TinyML die Cloud entlasten könnte und präsentieren Entwicklungsansätze und Herausforderungen.

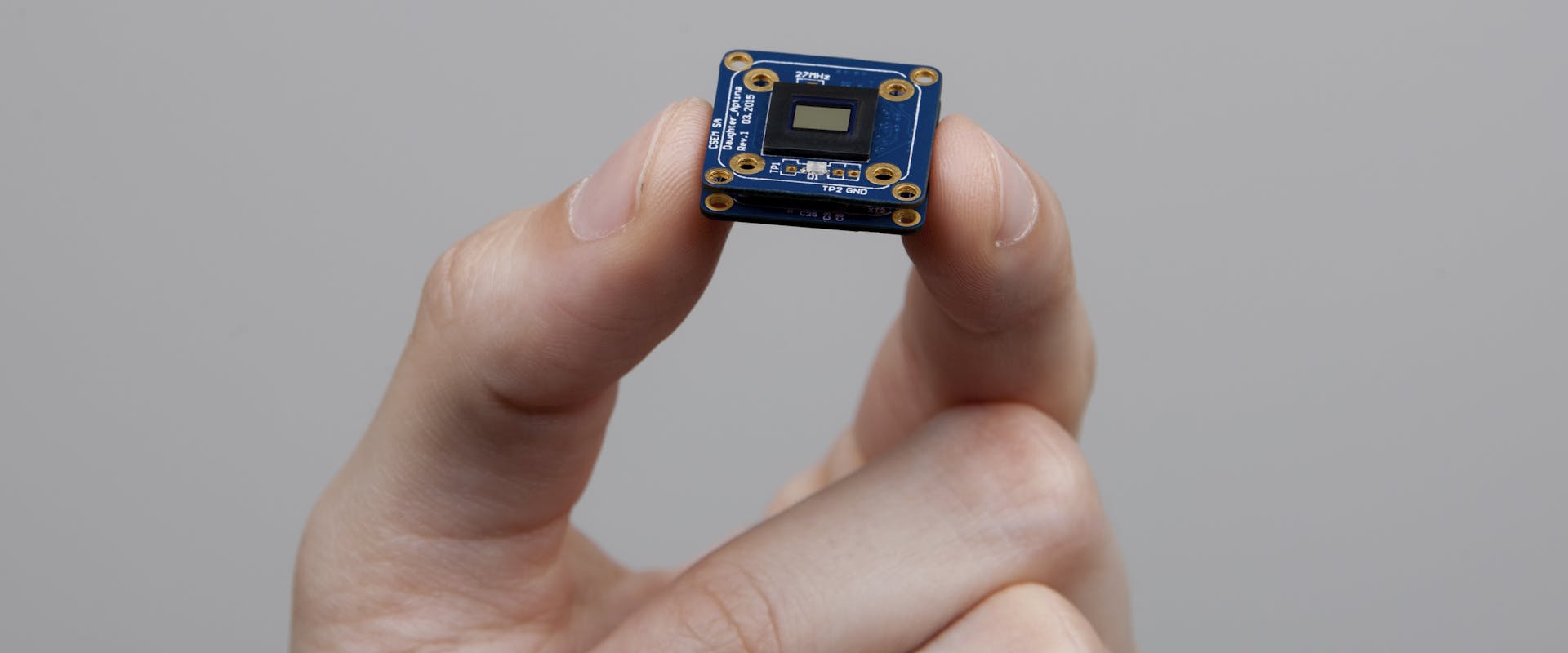

© CSEM - Das Vision-in-Package-Modul (VIP) ist ein effizientes mobiles Gerät für Computer Vision.